Een stickertje dat een mens amper opmerkt, kan een stopbord onherkenbaar maken voor een zichzelf besturende auto. Artificiële intelligentie mag dan in korte tijd veel krachtiger geworden zijn, ze blijkt erg kwetsbaar voor een totaal nieuw soort hacking. De Standaard doet omstandig uit de doeken hoe “adversial perturbations” een AI-systeem om de tuin kunnen leiden. En dat blijkt nog eens verrassend makkelijk te zijn.

Een stickertje dat een mens amper opmerkt, kan een stopbord onherkenbaar maken voor een zichzelf besturende auto. Artificiële intelligentie mag dan in korte tijd veel krachtiger geworden zijn, ze blijkt erg kwetsbaar voor een totaal nieuw soort hacking. De Standaard doet omstandig uit de doeken hoe “adversial perturbations” een AI-systeem om de tuin kunnen leiden. En dat blijkt nog eens verrassend makkelijk te zijn.

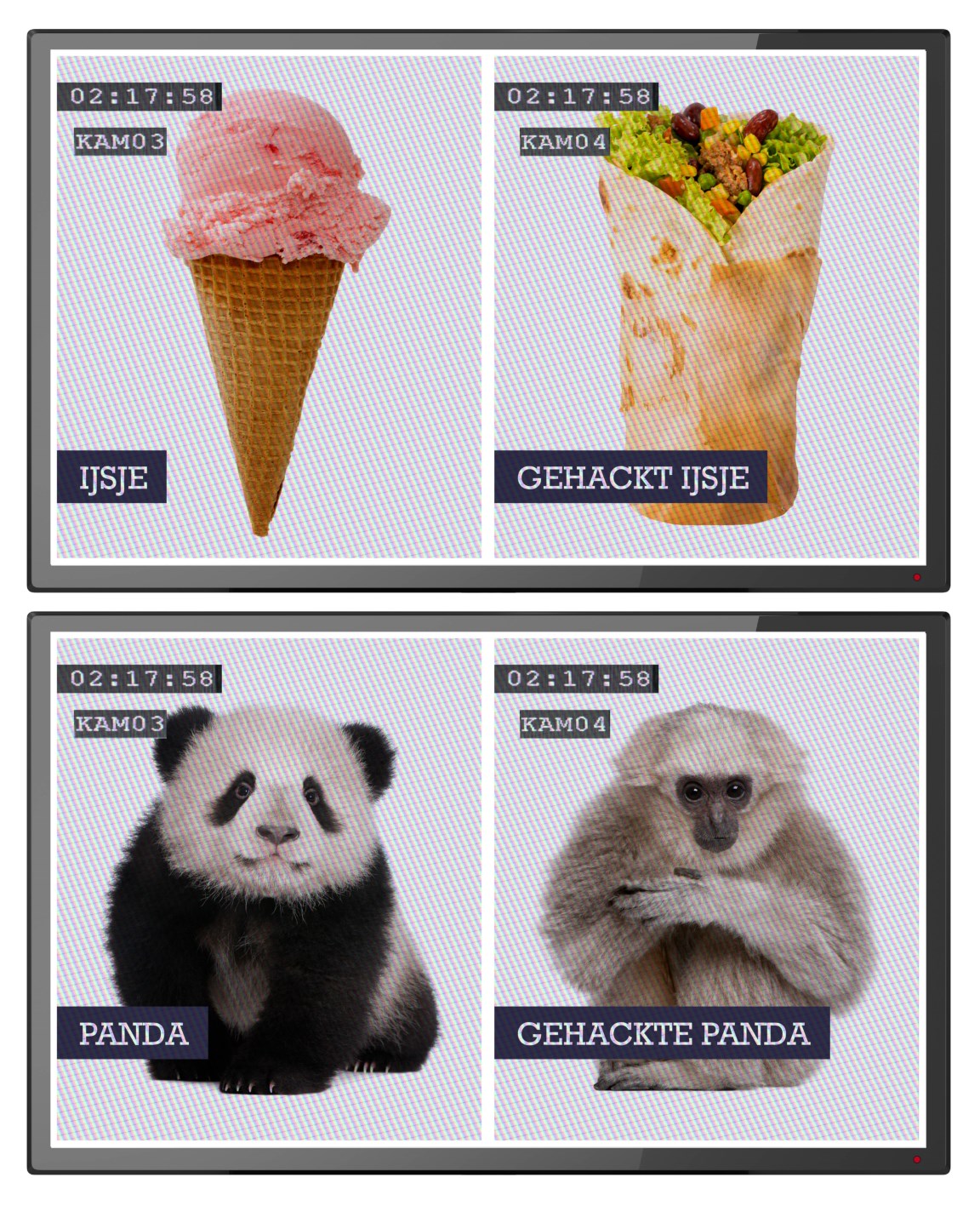

Een sticker kan vrijwel elk AI-systeem dat beelden herkent, op een dwaalspoor zetten. De klever bevat alleen een kluwen van lijnen en kleuren, maar is bijzonder machtig. Leg hem naast een banaan, en voor de computer is die banaan plots een broodrooster geworden. En wat met de camera’s die op luchthavens worden ingezet om gezochte terroristen te herkennen? Deze sticker, of een bril die op gelijkaardige patronen is gebaseerd, kan ervoor zorgen dat een terrorist gewoon kan doorlopen.

Je kunt adversarial perturbations overigens ook inzetten om jezelf te beschermen. Bijvoorbeeld tegen gezichtsherkenning.

Elke foto van u die online staat, kan in principe worden gebruikt om een AI-systeem te ‘trainen’ zodat het u kan herkennen op andere foto’s – of gewoon op straat (in de Chinese stad Shenzhen wordt gezichtsherkenning ingezet om mensen die door het rood lopen te vatten). Maar u kunt uw familiekiekjes onleesbaar maken voor AI-systemen. En u kunt op straat zelfs rondlopen met een speciale bril die de camera’s misleidt.

De beveiliging van AI-systemen is overigens een meer dan herkenbaar verhaal.

“Er wordt momenteel massaal geïnvesteerd in deep learning, terwijl er maar heel weinig mensen bezig zijn met de veiligheid’, constateert onderzoeker Bart Goossens. ‘Pas als het een keer echt foutloopt, gaat men daarin investeren. Er is nog veel fundamenteel onderzoek nodig om dit probleem op te lossen, maar intussen wordt deze technologie wel steeds meer in de praktijk gebracht.”

Lees het volledige artikel bij De Standaard (of hier)